AI行业应用

YOLOv9:实时对象检测,能够快速准确地在图像或视频中识别和定位多个对象

之前的YOLO系列模型相比,YOLOv9在不牺牲性能的前提下实现模型的轻量化,同时保持更高的准确率和效率。

这使得它可以在各种设备和环境中运行,如移动设备、嵌入式系统和边缘计算设备。

YOLOv9通过改进模型架构和训练方法,提高了对象检测的准确性和效率

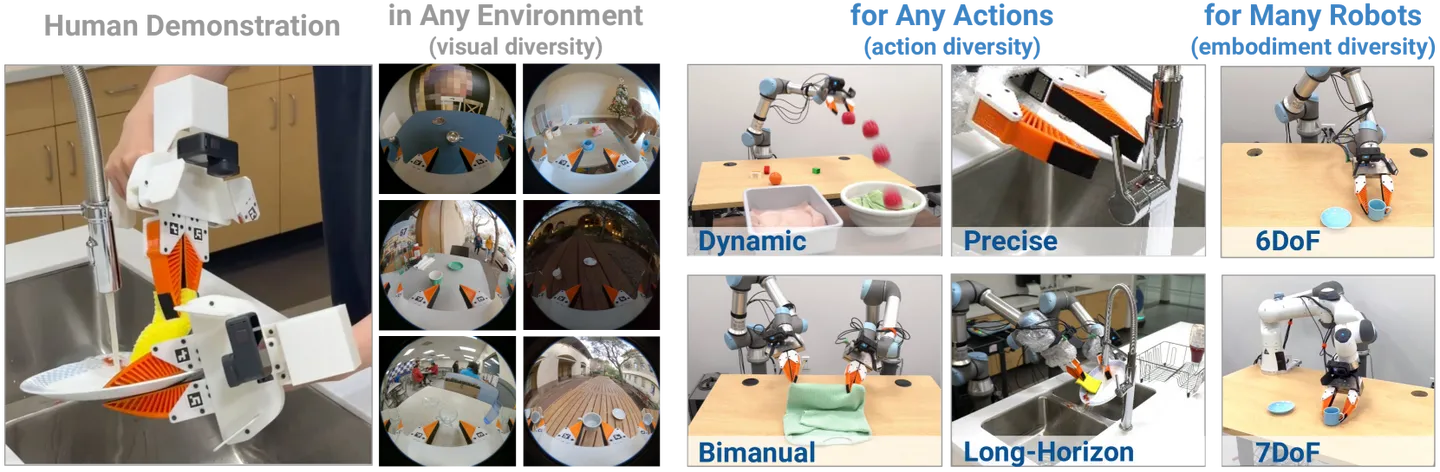

UMI:斯坦福开发的一个机器人数据收集和策略学习框架

UMI可以将人类在复杂环境下的操作技能直接转移给机器人,无需人类编写详细的编程指令。

也就是通过人类亲自操作演示然后收集数据,直接转移到机器人身上,使得机器人能够快速学习新任务

UMI整合了精心设计的策略接口,包括推理时延匹配和相对轨迹动作表示,使得学习到的策略不受硬件限制,可跨多个机器人平台部署。

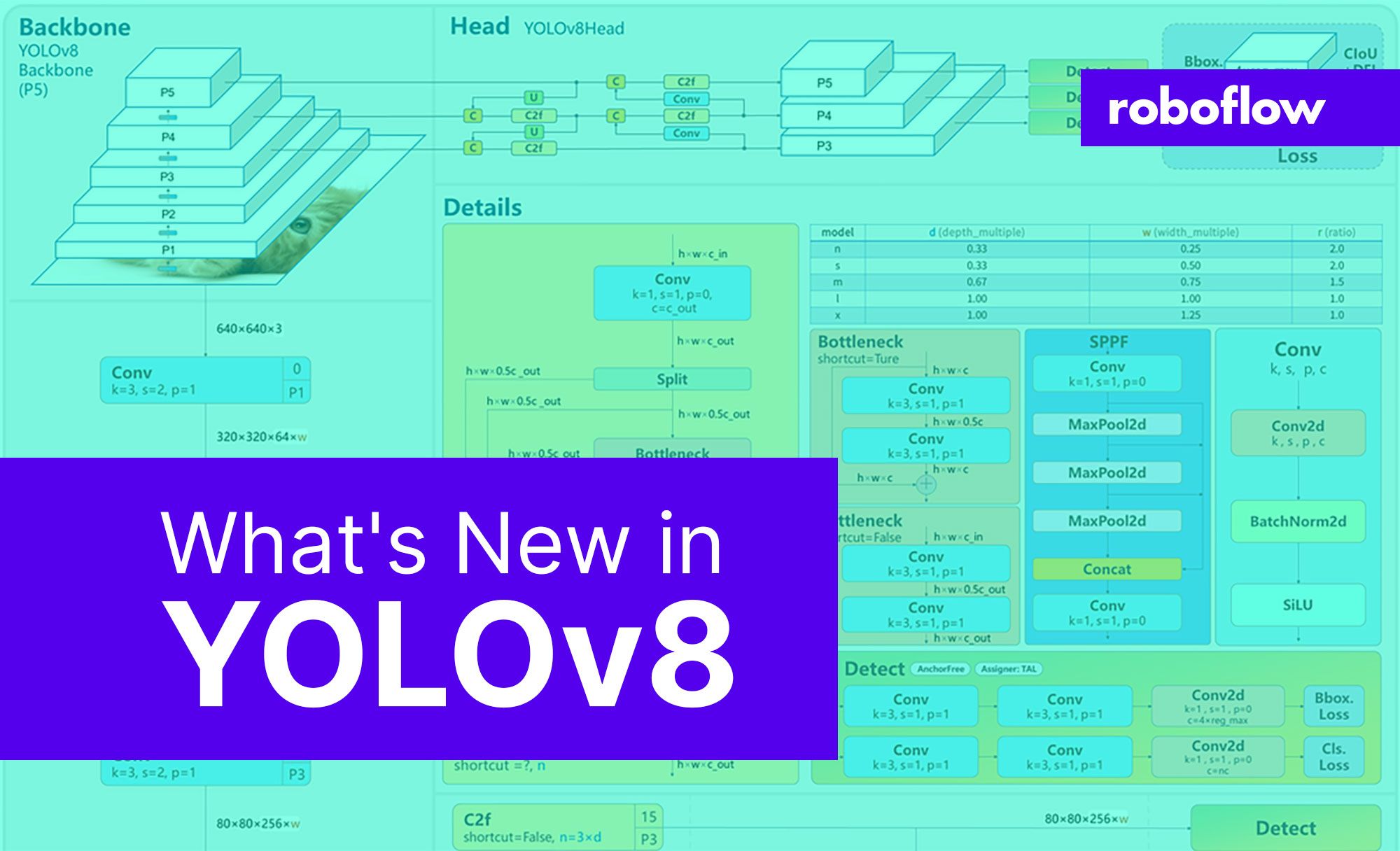

YOLOv8:目标检测跟踪模型

YOLOv8能够在图像或视频帧中快速准确地识别和定位多个对象,还能跟踪它们的移动,并将其分类。

除了检测对象,YOLOv8还可以区分对象的确切轮廓,进行实例分割、估计人体的姿态、帮助识别和分析医学影像中的特定模式等多种计算机视觉任务。

Google的一个新的视频模型:VideoPoet

它可以根据文字描述来生成视频。但它不是基于扩散模型,而本身就是个LLM,可以理解和处理多模态信息,并将它们融合到视频生成过程中。

不仅能生成视频,还能给视频加上风格化的效果,还可修复和扩展视频,甚至从视频中生成音频。

一条龙服务…

例如,VideoPoet 可以根据文本描述生成视频,或者将一张静态图片转换成动态视频。它还能理解和生成音频,甚至是编写用于视频处理的代码。

Vicarious :允许外科医生360度可视化和进入腹部的手术机器人

该机器人只需要1.5厘米的小切口来进行腹部手术,这比一枚硬币还小,大大减少了手术对患者身体的伤害和术后恢复时间。

1X’s :神经网络视觉端到端学习机器人

该机器人能够完全独立地执行任务,无需人类远程操控或通过预设脚本。

所有动作都是实时通过神经网络计算得出。

机器人基于视觉的端到端神经网络直接从图像中学习如何控制其动作,包括驾驶、操纵手臂和抓取器、控制躯干和头部等。

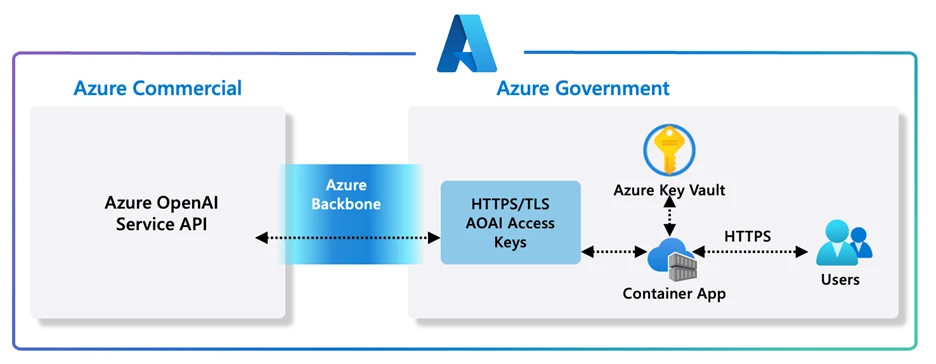

AzureOpenAIService宣布了一系列新功能

包括公开预览的Assistants API、新的文本到语音(TTS)功能、即将推出的GPT-4 Turbo和GPT-3.5 Turbo模型更新、新的嵌入模型以及微调API的更新。

与之前的聊天完成API相比,Assistants API能够记住之前的对话内容,创建持久化和无限长的线程。

Assistants API 是一项由 Azure OpenAI 提供的新服务,它旨在帮助开发者在他们的应用程序中更容易地创建高质量的人工智能助手体验。

Archax:是一款搭乘操作型机器人

通过驾驶舱进行直接操控,用户可以打开舱盖,进入驾驶舱,与机器人合为一体进行操控。

26个关节自由度,有机器人 / 车辆两种模式。

驾驶舱内部设有四面显示屏,用于显示机器人外部的摄像头画面。

研究人员正在帮助机器人变得敏捷、快速和安全

卡内基梅隆大学和苏黎世联邦理工学院的研究人员正在帮助机器人变得敏捷、快速和安全。

新框架允许以近 7 英里/小时的速度在杂乱的空间中导航而不会发生碰撞。

MetaVoice-1B:高度真实和自然的文本到语音(TTS)转换模型

模型有1.2亿个参数,经过了10万小时的语音数据训练。

专注英语情感演讲

跨语言语音克隆

支持美国和英国声音的零样本克隆

支持长篇内容语音合成

机器人技术即将迎来它的ChatGPT时刻

机器人初创公司@Figure_robot 发布了一段视频

他们家的Figure-01机器人现在可以自己煮咖啡了

这是一个使用了端到端的人工智能系统,仅通过观察人类制作咖啡的录像,10小时内学会了制作咖啡的技能。

OpenAI 和微软正在洽谈支持人形机器人公司Figure

报道披露了 OpenAI 和微软与人形机器人公司 Figure 的融资谈判。

此轮融资对Figure的估值接近$2B。

MedSAM:通用医学影像分割模型

MedSAM是一种医学影像分割工具,它能够自动识别和描绘医学影像中的重要区域,比如肿瘤或其他组织的病变。

通过学习大量医学影像和对应的掩模(即正确的分割结果),它能够处理各种不同的医学影像和复杂情况。

它可以帮助医生更快、更准确地诊断疾病。

AI医疗设备DermaSensor 刚刚获得FDA批准

能够检测所有主要皮肤癌的AI医疗设备DermaSensor 刚刚获得FDA批准

该设备能检测三种最常见的皮肤癌:黑色素瘤、基底细胞癌和鳞状细胞癌。

在1000多名患者的研究中,DermaSensor在检测224例皮肤癌方面表现出高灵敏度,正确阳性率为96%

WhisperSpeech:一个开源的文本到语音系统

是通过对OpenAI的Whisper语音识别模型反向工程来实现的。

通过这种反转过程,WhisperSpeech能够接收文本输入,并利用修改后的Whisper模型生成听起来自然的语音输出。

输出的语音在发音准确性和自然度方面都非常的优秀。